Trong thời đại số hóa hiện nay, việc xử lý thông tin ngày càng trở nên phức tạp. Đặc biệt, khi dùng các mô hình ngôn ngữ lớn (LLM) cho công việc hàng ngày, ai cũng lo lắng về vấn đề bảo mật và quyền riêng tư dữ liệu. Đây chính là lúc LocalGPT – một hệ thống Retrieval Augmented Generation (RAG) cục bộ – trở thành “người bạn đồng hành” không thể thiếu.

LocalGPT không chỉ giúp bạn trò chuyện với tài liệu cá nhân qua các mô hình AI chạy ngay trên máy tính mà còn là một công cụ mạnh mẽ để tối ưu hóa quy trình RAG. Với phiên bản 2.0 mới nhất, mình thực sự ấn tượng bởi những cải tiến vượt bậc về giao diện lẫn tính năng, mang đến trải nghiệm mượt mà và linh hoạt hơn bao giờ hết.

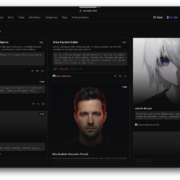

Giao diện mới rất đơn giản và dễ dùng

Phiên bản mới của LocalGPT làm mình bất ngờ với giao diện được thiết kế lại, gọn gàng và dễ dùng hơn rất nhiều. Ngay khi mở ứng dụng, bạn sẽ thấy ba lựa chọn chính:

- Tạo index mới (Create new index): Bạn có thể tải tài liệu lên và tạo cơ sở dữ liệu để tìm kiếm. Đây là bước đầu tiên để LocalGPT “hiểu” dữ liệu của bạn.

- Dùng index có sẵn (Chat with index): Nếu đã tạo index trước đó, bạn chỉ cần chọn và tiếp tục làm việc mà không cần xử lý lại. Rất tiện nếu bạn muốn thử nhiều cách cấu hình khác nhau.

- Trò chuyện trực tiếp với AI cục bộ (LLM Chat): Tính năng này siêu hay! Bạn có thể chat ngay với mô hình AI trên máy tính mà không cần qua bước truy xuất tài liệu.

Mình đặc biệt thích việc LocalGPT tích hợp với Ollama – một nền tảng chạy LLM cục bộ. Nhờ vậy, bạn tận dụng được sức mạnh của các mô hình AI mã nguồn mở mà không phải gửi dữ liệu ra ngoài, đảm bảo thông tin luôn an toàn.

Tối ưu indexing và truy xuất: bí quyết để RAG hiệu quả

Muốn hệ thống RAG hoạt động tốt, bạn cần có index chất lượng và cách truy xuất thông minh. LocalGPT 2.0 mang đến nhiều tùy chọn để bạn tùy chỉnh theo ý muốn.

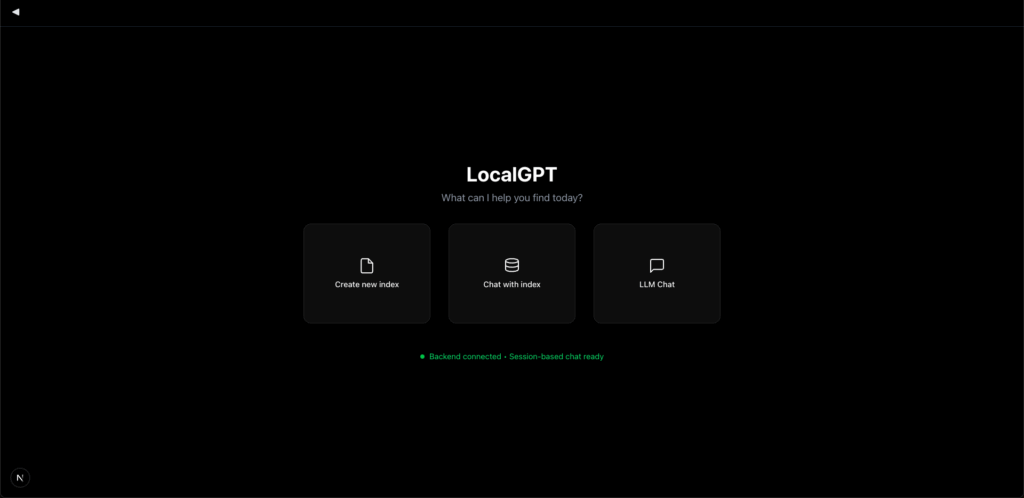

Cách tạo index đỉnh cao

Khi tạo index, bạn sẽ có những lựa chọn sau:

- Tìm kiếm lai (Hybrid Search): mình luôn chọn cái này. Nó kết hợp tìm kiếm vector và tìm kiếm văn bản đầy đủ, giúp hệ thống vừa hiểu ý nghĩa câu hỏi vừa tìm đúng từ khóa. Kết quả chính xác hơn hẳn!

- Phân đoạn trễ (Late Chunking): Đây là kỹ thuật nâng cao, chưa bật sẵn. Nó giữ ngữ cảnh rộng hơn bằng cách chia nhỏ dữ liệu khi cần truy xuất.

- Phân đoạn câu (Sentence-Level Chunking): Chia tài liệu theo từng câu để thông tin chính xác hơn. Nhưng lưu ý, cách này tạo nhiều đoạn nhỏ nên mất thời gian hơn. Bạn nên thử vài cấu hình để tìm cái phù hợp nhất.

- Chọn mô hình Embedding: LocalGPT hỗ trợ cả embedding mặc định và mô hình từ Olama. Bạn có thể chọn tùy theo máy tính và nhu cầu.

Tăng chất lượng với tổng quan và ngữ cảnh

LocalGPT còn có hai tính năng mình rất thích:

- Tổng quan tài liệu: Hệ thống tự tạo tóm tắt ngắn từ vài đoạn ngẫu nhiên trong tài liệu. Nhờ vậy, AI biết khi nào nên dùng dữ liệu từ index hay kiến thức có sẵn.

- Truy xuất ngữ cảnh: Thay vì chỉ lấy một đoạn, LocalGPT xem xét thêm 5 đoạn xung quanh để giữ ngữ cảnh đầy đủ. Cách này làm câu trả lời sâu sắc và chính xác hơn, đặc biệt với câu hỏi phức tạp.

Tùy chỉnh RAG: Bạn làm chủ mọi thứ

LocalGPT 2.0 không chỉ tạo index mà còn cho bạn kiểm soát toàn bộ quy trình RAG.

Xử lý câu hỏi khó

Với câu hỏi phức tạp, LocalGPT chia nhỏ thành các câu hỏi con. Bạn có thể:

- Trả lời từng phần: AI giải quyết từng câu hỏi con riêng lẻ.

- Tổng hợp thông tin: Lấy hết đoạn liên quan rồi để AI gộp lại thành câu trả lời hoàn chỉnh.

Điều chỉnh truy xuất

Bạn có thể tinh chỉnh nhiều thứ:

- Số Đoạn Lấy Ban Đầu: Mặc định là 20, nhưng mình hay thử giảm xuống 10 hoặc 5 để cân bằng tốc độ và độ chính xác.

- Xếp Hạng Lại (Reranker): Chọn ra 10 đoạn phù hợp nhất từ những đoạn đã lấy.

- Mở Rộng Ngữ Cảnh: Thêm thông tin xung quanh các đoạn được chọn.

- Cắt Tỉa (Pruning): Loại bỏ câu không liên quan trong mỗi đoạn, giúp AI tập trung vào thông tin quan trọng.

Kiểm tra độ tin cậy

LocalGPT còn hiển thị điểm tin cậy cho câu trả lời. Nó dùng một AI khác để đánh giá độ chính xác, nhưng tính năng này hơi chậm (mất 5-10 giây). Nếu cần nhanh, bạn có thể tắt đi.

Mẹo dùng LocalGPT hiệu quả

Dùng một thời gian, mình rút ra vài mẹo:

- Dùng từ khóa rõ ràng: Giúp hệ thống tìm đúng thông tin hơn.

- Buộc truy xuất: Thêm cụm “theo tài liệu này” hoặc bật “Rag Node Triage” để đảm bảo dùng dữ liệu từ index.

- Thay đổi câu hỏi: Nếu không hài lòng với đáp án cũ, hỏi lại theo cách khác để tránh dùng cache.

Cách cài đặt LocalGPT 2.0

Cài LocalGPT 2.0 khá dễ. Đây là các bước cơ bản:

- Tải source code:

git clone -b localgpt-v2 https://github.com/PromtEngineer/localGPT.git localgpt_v2

cd localgpt_v2- Tạo môi trường Python:

conda create -n localgpt_env python=3.11

conda activate localgpt_env- Cài thư viện:

pip install -r requirements.txt- Chạy chương trình:

- Cách nhanh:

python system.py - Cách chi tiết (Dùng 3 Terminal):

- Tab 1:

python backend_server.py - Tab 2:

python rag_system_api_server.py - Tab 3:

npm run dev(Cần cài NodeJS trước).

- Tab 1:

Sau đó, mở trình duyệt vào http://localhost:3000 để dùng.

LocalGPT 2.0 là một bước tiến lớn cho ai muốn xây dựng hệ thống RAG riêng tư. Với giao diện đẹp, tính năng mạnh mẽ và khả năng tùy ubndn tùy chỉnh, đây là công cụ hoàn hảo cho những người quan tâm đến quyền riêng tư và hiệu suất AI.

Mình thực sự khuyên bạn nên tải về và thử ngay hôm nay. LocalGPT không chỉ là chatbot mà còn là cách khai thác dữ liệu cá nhân an toàn, hiệu quả. Hãy trải nghiệm và chia sẻ cảm nhận để cùng phát triển dự án này nhé!