Exo: Hướng dẫn biến thiết bị cũ thành “siêu máy tính” AI tại nhà

Hello ae,

Có bao giờ ae ngồi nhìn dàn PC cũ, chiếc MacBook đời cũ hay mấy con Raspberry Pi nằm phủ bụi và tự hỏi: “Liệu mình có thể làm gì hay ho với đống này không?”. Hoặc có khi nào ae cảm thấy xót ruột mỗi khi nhận bill từ OpenAI API, hay đơn giản là lo sợ dữ liệu nhạy cảm của mình bị gửi lên server của các ứng dụng AI?

Nếu câu trả lời là có, thì hôm nay mình mang đến cho ae một giải pháp mà mình tin là “chân ái”. Đó là Exo.

Đây là một dự án mã nguồn mở đang cực kỳ hot, cho phép ae biến những thiết bị rời rạc hàng ngày – từ iPhone, laptop cũ cho đến máy bàn gaming – thành một cụm AI phân tán (AI cluster) mạnh mẽ. AE sẽ chạy được những mô hình xịn xò như Llama 3 hay DeepSeek ngay tại nhà, hoàn toàn miễn phí và bảo mật tuyệt đối.

Hãy pha một cốc cafe, và cùng mình đi sâu vào hướng dẫn chi tiết này nhé!

Exo là gì?

Hãy tưởng tượng Exo giống như việc lắp ráp robot trong phim siêu nhân vậy. Từng thiết bị riêng lẻ có thể yếu, nhưng khi kết hợp lại, chúng tạo thành một thực thể mạnh mẽ.

Về mặt kỹ thuật, Exo là một dự án open-source từ Exo Labs giúp kết nối các thiết bị có sẵn để chạy các mô hình ngôn ngữ lớn (LLMs). Điểm “ăn tiền” nhất của Exo là nó không yêu cầu ae phải sở hữu một con GPU H100 hay A100 đắt đỏ. Nó tận dụng bộ nhớ RAM của tất cả các thiết bị cộng lại để chứa model.

Những tính năng “đáng đồng tiền bát gạo”

- Hỗ trợ đa nền tảng: AE có gì dùng nấy. iPhone, iPad, điện thoại Android, Mac, Linux, NVIDIA GPU, hay thậm chí là Raspberry Pi và đồng hồ thông minh (smartwatch).

- Phân chia mô hình động (Dynamic Model Partitioning): Đây là tính năng thông minh nhất. Exo sẽ tự động “chia” mô hình AI ra thành nhiều phần nhỏ và chia cho từng thiết bị dựa trên khả năng của chúng. Ví dụ: AE muốn chạy Llama 3.1 405B (siêu nặng), Exo sẽ chia tải cho 2 chiếc MacBook Air 8GB.

- Tự động khám phá (Auto-discovery): Quên đi việc cấu hình IP thủ công hay setup mạng phức tạp. Các thiết bị chạy Exo sẽ tự tìm thấy nhau qua mạng P2P (ngang hàng), không cần máy chủ trung tâm.

- API chuẩn ChatGPT: AE đang code app dùng OpenAI API? Chỉ cần đổi 1 dòng code trỏ về Exo là xong. Nó hỗ trợ đủ các “hàng tuyển” hiện nay: LLaMA, Mistral, Qwen, DeepSeek, LLaVA.

Tại sao ae nên thử Exo ngay hôm nay?

Mình tin rằng có 4 lý do chính khiến Exo trở thành một dự án không thể bỏ qua:

- Tiết kiệm chi phí tối đa: Thay vì trả $0.03 – $0.30 cho mỗi 1K tokens (khá chát nếu dùng nhiều), chi phí duy nhất ae tốn là tiền điện. Tận dụng phần cứng có sẵn là cách kinh tế nhất.

- Bảo mật & Quyền riêng tư: Dữ liệu của ae là của ae. Mọi thứ xử lý offline trong mạng nội bộ. Không ai (kể cả Exo Labs hay OpenAI) biết ae đang hỏi gì. Cực kỳ phù hợp cho các dự án nội bộ công ty hoặc dữ liệu cá nhân nhạy cảm.

- Kiểm soát toàn diện: AE là chủ hệ thống. Không lo bị khóa tài khoản, không lo bị giới hạn tốc độ (rate limit) từ nhà cung cấp dịch vụ.

- Sức mạnh cộng đồng: Với hơn 32,000 stars trên GitHub và 2,200+ forks, cộng đồng Exo đang phát triển cực nhanh, đồng nghĩa với việc hỗ trợ và cập nhật tính năng mới liên tục.

Yêu cầu hệ thống & chuẩn bị “đồ nghề”

Trước khi xắn tay áo vào làm, chúng ta cần kiểm tra túi đồ nghề xem đã đủ chưa nhé.

Yêu cầu phần mềm

Đây là điểm quan trọng nhất mà nhiều ae hay mắc lỗi:

- Python >= 3.12.0: Bắt buộc phải từ bản này trở lên. Các bản cũ hơn sẽ gặp lỗi với thư viện

asyncio. - Với Linux + NVIDIA GPU: AE cần cài đủ bộ tam này:

- NVIDIA Driver (kiểm tra bằng lệnh

nvidia-smi). - CUDA Toolkit (kiểm tra bằng

nvcc --version). - cuDNN Library.

- NVIDIA Driver (kiểm tra bằng lệnh

Yêu cầu phần cứng

Quy tắc vàng: Tổng RAM của tất cả thiết bị cộng lại >= Dung lượng yêu cầu của Model.

Dưới đây là bảng tham khảo để ae dễ hình dung:

| Mô hình (Model) | Yêu cầu RAM | Cấu hình ví dụ tham khảo |

|---|---|---|

| Llama 3.2 3B | 6GB | 1x Mac Mini 8GB (Dư sức chạy) |

| Llama 3.1 8B | 16GB | 2x MacBook Air M3 8GB (Kết hợp lại) |

| Llama 3.1 70B | 140GB | 2x RTX 4090 + 1x Mac Mini (Cấu hình khủng) |

| DeepSeek R1 671B | 1.3TB | Cụm 10+ thiết bị (Dành cho tay chơi lớn) |

Hướng dẫn cài đặt từng bước

Đừng lo nếu ae không quá rành kỹ thuật, cứ làm theo đúng từng bước dưới đây là được.

Bước 1: Cài đặt Python 3.12+

Đầu tiên, mở Terminal và kiểm tra xem máy ae đang chạy Python mấy:

python3 --versionNếu phiên bản thấp hơn 3.12, ae cần nâng cấp ngay.

- macOS (dùng Homebrew):

brew install [email protected]- Ubuntu/Debian:

sudo apt-get update sudo apt-get install python3.12 python3.12-venvBước 2: Clone repository & cài đặt Exo

Chúng ta sẽ lấy mã nguồn về và cài đặt. Mình khuyên ae nên dùng môi trường ảo (Virtual Environment) để tránh xung đột thư viện.

# Clone dự án từ GitHub

git clone https://github.com/exo-explore/exo.git

cd exo

# Cách 1: Cài đặt trực tiếp (Nhanh gọn)

pip install -e .

# Cách 2: Sử dụng Virtual Environment (Khuyên dùng - Best Practice)

source install.shLƯU Ý:

Quá trình này có thể mất 5-10 phút tùy vào mạng của ae, hãy kiên nhẫn nhé.Bước 3: Cấu hình cho macOS (Dành riêng cho Apple Silicon)

Nếu ae đang dùng máy Mac chạy chip M1/M2/M3/M4, đừng bỏ qua bước này. Nó giúp tối ưu hóa GPU của Apple (Metal).

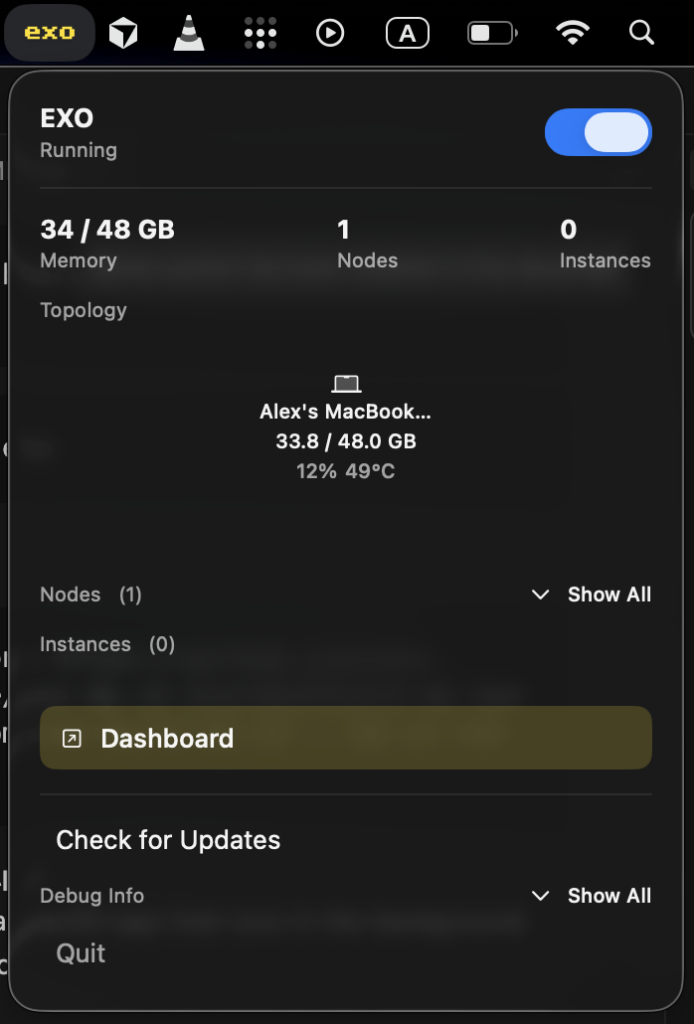

./configure_mlx.shÀ exo cũng đã có ứng dụng macOS (EXO-latest.dmg) để ae theo dõi. Hỗ trợ từ macOS Tahoe 26.2 trở lên. Khi mở lần đầu, app sẽ yêu cầu quyền sửa đổi cài đặt hệ thống và cài đặt cấu hình Mạng mới nhé ae.

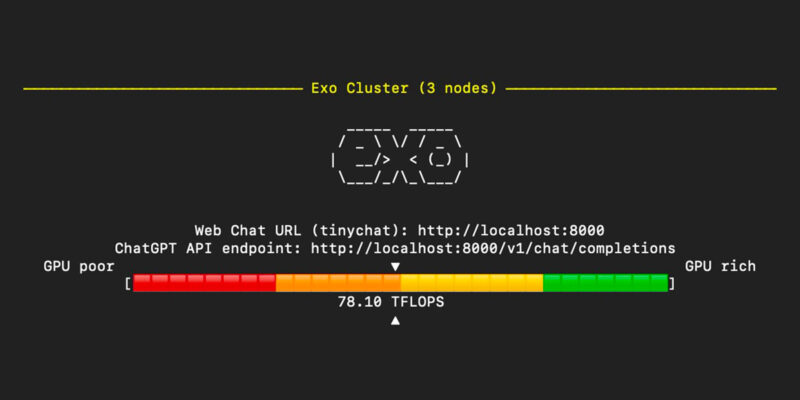

Bước 4: Khởi động Exo

Giờ là lúc “bấm nút” kích hoạt cụm AI của ae.

- Nếu chỉ có 1 thiết bị:

exo - Nếu có nhiều thiết bị (Ví dụ: 1 Mac, 1 Laptop Linux):

AE chỉ cần chạy lệnhexotrên cả hai máy. Exo sẽ tự động quét mạng LAN và kết nối chúng lại với nhau như ma thuật!

# Trên thiết bị 1 (Mac)

exo

# Trên thiết bị 2 (Linux)

exoSau khi khởi động thành công, ae sẽ thấy thông báo và có thể truy cập giao diện web tại:http://localhost:52415

Sử dụng Exo: Các ví dụ thực tế

Để giúp ae dễ hình dung sức mạnh của Exo, mình sẽ demo vài trường hợp sử dụng cụ thể.

Ví dụ 1: Giao diện Web (Dễ nhất – Dành cho người mới)

Mở trình duyệt, vào http://localhost:52415. Giao diện này nhang nhác ChatGPT, ae chỉ cần gõ câu hỏi và chờ AI trả lời. Rất trực quan.

Ví dụ 2: Sử dụng API (Dành cho Dev)

Nếu ae muốn tích hợp vào code, hãy dùng curl để test API. Nó tương thích hoàn toàn với OpenAI format.

# Test câu hỏi cơ bản

curl http://localhost:52415/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "llama-3.2-3b",

"messages": [{"role": "user", "content": "Exo là gì?"}],

"temperature": 0.7

}'Ví dụ 3: Chạy mô hình “Khủng long” (405B Parameters)

Thử thách sức mạnh của cụm máy tính với model Llama 3.1 405B:

curl http://localhost:52415/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "llama-3.1-405b",

"messages": [{"role": "user", "content": "Giải thích về machine learning"}],

"temperature": 0.7

}'Ví dụ 4: Xử lý hình ảnh (Vision Model)

Exo không chỉ biết đọc, nó còn biết “nhìn”. Thử nghiệm với LLaVA:

curl http://localhost:52415/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "llava-1.5-7b-hf",

"messages": [

{

"role": "user",

"content": [

{"type": "text", "text": "Hình ảnh này có gì?"},

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}}

]

}

],

"temperature": 0.0

}'Ví dụ 5: Lệnh nhanh (One-liner)

Đôi khi ae chỉ muốn chạy nhanh một câu lệnh mà không cần bật server hay API phức tạp:

# Chạy Llama 3.2 3B với prompt tùy chỉnh

exo run llama-3.2-3b --prompt "Viết một bài thơ về lập trình"Các mô hình được hỗ trợ

Exo hỗ trợ hầu hết các “ngôi sao” trên Hugging Face hiện nay. AE có thể thay đổi tên model trong lệnh exo run:

- LLaMA Series: 3B, 8B, 70B, 405B (Đủ mọi kích cỡ).

- Mistral: 7B, 8x7B MoE (Mixture of Experts).

- Qwen: Dòng model rất mạnh từ Alibaba.

- DeepSeek: R1 (671B), Coder (Chuyên code).

- LLaVA: Vision-language (Xử lý ảnh).

- Phi: Dòng model nhỏ gọn nhưng “có võ” của Microsoft.

Khắc phục sự cố thường gặp (Troubleshooting)

Trong quá trình vọc vạch, chắc chắn sẽ có lỗi. Dưới đây là cách xử lý những lỗi mình hay gặp nhất:

1. Lỗi: “Python version too old”

- Nguyên nhân: AE đang dùng Python < 3.12.

- Giải pháp: Cài bản mới và chạy lại lệnh cài đặt:

python3.12 -m pip install -e .

2. Lỗi SSL Certificate trên macOS

- Hiện tượng: Báo lỗi kết nối SSL khi tải model.

- Giải pháp: Chạy script cài chứng chỉ đi kèm Python:

/Applications/Python\ 3.12/Install\ Certificates.command

3. Máy chủ treo hoặc không phản hồi

- Giải pháp: Bật chế độ debug để xem lỗi gì đang xảy ra:

DEBUG=9 exo

4. Các thiết bị không tìm thấy nhau

- Nguyên nhân: Khác mạng Wi-Fi hoặc bị chặn bởi Firewall.

- Giải pháp: Đảm bảo cùng mạng LAN. Nếu ae muốn kết nối từ xa (khác mạng), hãy dùng Tailscale (Exo hỗ trợ rất tốt):

exo --tailscale

5. Tốc độ quá chậm

- Giải pháp:

- Nâng cấp macOS lên bản Sequoia mới nhất (tối ưu driver rất tốt).

- Ưu tiên dùng thiết bị có GPU, hạn chế dùng CPU thuần.

- “Liệu cơm gắp mắm”: Đừng cố chạy model 70B trên máy cấu hình yếu, hãy thử bản 3B hoặc 8B trước.

Mẹo tối ưu hóa hiệu suất (Pro Tips)

Để cụm AI của ae chạy mượt mà nhất, hãy lưu ý:

- Phần cứng là vua: Thêm GPU luôn hiệu quả hơn thêm CPU.

- Cấu hình MLX: Luôn nhớ chạy

./configure_mlx.shnếu có máy Mac trong cụm. - Quản lý bộ nhớ: Mặc định model lưu ở

~/.cache/exo/downloads. Nếu ổ cứng đầy, ae có thể chuyển sang ổ cứng ngoài bằng cách set biến môi trường:export EXO_HOME=/path/to/custom/location exo

Exo thực sự là một bước ngoặt thay đổi cuộc chơi. Nó chuyển quyền lực từ các trung tâm dữ liệu khổng lồ về ngay phòng làm việc của ae. Nó cho phép chúng ta tận dụng lại những thiết bị điện tử cũ, biến chúng thành một hệ thống có ích, an toàn và mạnh mẽ.

Dù ae là một lập trình viên muốn vọc vạch LLM, một nhà nghiên cứu cần môi trường private, hay chỉ đơn giản là một người yêu công nghệ thích DIY, Exo là dự án ae nhất định phải thử.

Hãy bắt đầu nhỏ (với model 3B), hiểu cách nó vận hành, rồi từ từ mở rộng “đế chế” AI của riêng ae.

AE đã sẵn sàng chưa? Hãy thử cài đặt Exo ngay hôm nay và chia sẻ kết quả với mình nhé!