Crawl4AI – Công cụ thu thập dữ liệu web cho AI

Nếu bạn đã từng làm việc trong lĩnh vực AI, đặc biệt là xây dựng các hệ thống RAG (Retrieval-Augmented Generation), bạn chắc chắn hiểu rõ “nỗi đau” của việc thu thập dữ liệu: dữ liệu web cực kỳ lộn xộn.

Trong nhiều năm, chúng ta đã phải vật lộn với các công cụ như BeautifulSoup, vốn chỉ là một thư viện phân tích HTML và “bó tay” với JavaScript. Chúng ta cũng đã thử Scrapy, một framework mạnh mẽ nhưng phức tạp và vẫn gặp khó khăn với nội dung động. Hoặc chúng ta phải dùng đến Selenium/Playwright, chấp nhận sự phức tạp của việc quản lý driver và viết logic chờ (wait) phiền phức.

Nhưng vấn đề lớn nhất là: các công cụ này được thiết kế để trích xuất dữ liệu có cấu trúc (như giá cả, bảng biểu). Ngày nay, chúng ta cần văn bản sạch (nội dung tài liệu, bài blog) để nạp vào các mô hình LLM.

Đây là lúc Crawl4AI xuất hiện. Crawl4AI là một thư viện mã nguồn mở Python được thiết kế đặc biệt để giải quyết bài toán này – biến nội dung web thành dữ liệu sạch, có cấu trúc và sẵn sàng cho các mô hình ngôn ngữ lớn (LLM).

Crawl4AI là gì?

Crawl4AI là một web crawler và scraper mã nguồn mở, được tối ưu hóa đặc biệt cho các ứng dụng AI. Khác với các công cụ thu thập dữ liệu truyền thống như BeautifulSoup hay Scrapy, Crawl4AI được thiết kế từ đầu với mục tiêu chuyển đổi nội dung web thành các định dạng thân thiện với AI như Markdown sạch, JSON có cấu trúc, hoặc dữ liệu đã được lọc nhiễu.

Với hơn 55,000+ stars trên GitHub và cộng đồng 50,000+ developer đang sử dụng, Crawl4AI đã trở thành công cụ web crawling phổ biến nhất cho các ứng dụng AI.

Tại sao nên chọn Crawl4AI?

Crawl4AI nổi bật so với các công cụ khác như BeautifulSoup và Scrapy nhờ những ưu điểm vượt trội:

- Tối ưu cho LLM và AI: Tự động tạo Markdown sạch với định dạng chuẩn, bao gồm tiêu đề, bảng, code và citation hints – hoàn hảo cho RAG và fine-tuning.

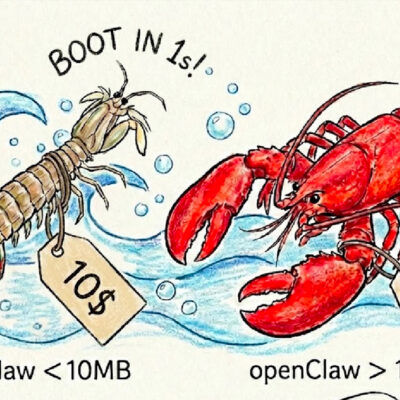

- Hiệu suất vượt trội: Nhanh hơn gấp 6 lần so với các giải pháp truyền thống nhờ kiến trúc async, browser pooling và caching thông minh.

- Kiểm soát toàn diện: Hỗ trợ session management, proxy authentication, cookies, user scripts và custom hooks cho mọi kịch bản crawling phức tạp.

- Trí tuệ thích ứng: Sử dụng thuật toán BM25 và heuristic để tự động học pattern của website, loại bỏ nội dung không cần thiết và chỉ trích xuất thông tin quan trọng.

- Dễ dàng triển khai: Không cần API key, có CLI và Docker, cloud-friendly và tích hợp mượt mà với LangChain, LlamaIndex và các framework AI phổ biến.

Ứng dụng thực tế

Crawl4AI được sử dụng rộng rãi trong các trường hợp sau:

- Xây dựng hệ thống RAG: Thu thập dữ liệu web real-time làm nguồn tri thức cho chatbot và AI assistant

- Data pipeline cho AI: Tạo dataset sạch để huấn luyện và fine-tune mô hình ngôn ngữ

- Nghiên cứu và phân tích: Thu thập dữ liệu từ tin tức, blog, documentation để phân tích xu hướng

- E-commerce scraping: Trích xuất thông tin sản phẩm có cấu trúc từ hàng nghìn trang web

- Content monitoring: Theo dõi thay đổi nội dung website tự động

Hướng dẫn cài đặt

Yêu cầu hệ thống

Trước khi bắt đầu, đảm bảo máy tính của bạn đáp ứng các yêu cầu sau:

- Python 3.10 trở lên (khuyến nghị Python 3.10+)

- pip (thường đi kèm với Python)

- Terminal/Command Line để chạy các lệnh

- Code editor như VS Code, PyCharm hoặc Jupyter Notebook

Cài đặt cơ bản qua pip

Cách cài đặt Crawl4AI đơn giản nhất là sử dụng pip. Mở terminal và chạy các lệnh sau:

# Cài đặt package

pip install -U crawl4ai

# Chạy setup để cấu hình browser (Playwright)

crawl4ai-setup

# Kiểm tra cài đặt

crawl4ai-doctorLệnh crawl4ai-setup sẽ tự động cài đặt và cấu hình Playwright (engine browser để crawl dynamic content).

Xử lý vấn đề Playwright thường gặp

Nếu gặp lỗi liên quan đến Playwright, bạn có thể cài đặt thủ công bằng một trong hai cách sau:

# Cách 1: Cài đặt Playwright cơ bản

playwright install

# Cách 2: Cài đặt Chromium với dependencies (khuyến nghị)

python -m playwright install --with-deps chromiumCách thứ hai thường ổn định hơn vì nó cài đặt cả các thư viện hệ thống cần thiết.

Cài đặt cho development

Nếu bạn muốn đóng góp vào dự án hoặc tùy chỉnh source code, hãy clone repository và cài đặt ở chế độ editable:

# Clone repository

git clone https://github.com/unclecode/crawl4ai.git

cd crawl4ai

# Cài đặt ở chế độ development

pip install -e .

# Cài đặt với các tính năng optional

pip install -e ".[torch]" # Với PyTorch features

pip install -e ".[transformer]" # Với Transformer features

pip install -e ".[all]" # Tất cả tính năngKiểm tra cài đặt

Sau khi cài đặt xong, kiểm tra xem mọi thứ hoạt động đúng bằng script Python đơn giản này:

import asyncio

from crawl4ai import AsyncWebCrawler

async def test_install():

async with AsyncWebCrawler() as crawler:

result = await crawler.arun("https://example.com")

print(f"✓ Crawl thành công! Độ dài markdown: {len(result.markdown)} ký tự")

if __name__ == "__main__":

asyncio.run(test_install())Nếu script chạy thành công và in ra độ dài markdown, bạn đã cài đặt thành công Crawl4AI!

Xử lý lỗi thường gặp

Một số vấn đề phổ biến và cách khắc phục:

- Lỗi “Module not found”: Kiểm tra lại pip install và đảm bảo đang dùng đúng Python environment.

- Timeout khi crawl: Tăng timeout trong

CrawlerRunConfighoặc kiểm tra kết nối mạng. - Browser không khởi động: Chạy lại

playwright install --with-deps chromiumvới quyền admin. - Lỗi certificate (SSL): Thêm

ignore_https_errors=TruevàoBrowserConfignếu crawl các site test.

Hướng dẫn sử dụng

Crawling cơ bản

Sau khi cài đặt xong, bạn có thể bắt đầu crawl website với ví dụ đơn giản sau:

import asyncio

from crawl4ai import AsyncWebCrawler

async def basic_crawl():

# Khởi tạo crawler trong async context

async with AsyncWebCrawler() as crawler:

# Crawl một URL

result = await crawler.arun(url="https://www.nbcnews.com/business")

# In ra markdown (đã được làm sạch tự động)

print(result.markdown[:500]) # In 500 ký tự đầu

# Kiểm tra trạng thái

if result.success:

print(f"✓ Crawl thành công! Tổng số từ: {len(result.markdown.split())}")

if __name__ == "__main__":

asyncio.run(basic_crawl())AsyncWebCrawler sử dụng Playwright để render JavaScript và xử lý dynamic content một cách tự động.

Trích xuất dữ liệu có cấu trúc với CSS Selector

Crawl4AI cho phép bạn trích xuất dữ liệu có cấu trúc mà không cần LLM, chỉ cần định nghĩa schema JSON với CSS selectors:

import asyncio

import json

from crawl4ai import AsyncWebCrawler, BrowserConfig, CrawlerRunConfig, CacheMode

from crawl4ai import JsonCssExtractionStrategy

async def extract_structured_data():

# Định nghĩa schema với CSS selectors

schema = {

"name": "Product Information",

"baseSelector": "div.product-card", # Container chứa các items

"fields": [

{

"name": "product_name",

"selector": "h3.product-title",

"type": "text",

},

{

"name": "price",

"selector": "span.price",

"type": "text",

},

{

"name": "image_url",

"selector": "img.product-image",

"type": "attribute",

"attribute": "src"

}

]

}

# Tạo extraction strategy

extraction_strategy = JsonCssExtractionStrategy(schema, verbose=True)

# Cấu hình crawler

browser_config = BrowserConfig(headless=True, verbose=True)

run_config = CrawlerRunConfig(

extraction_strategy=extraction_strategy,

cache_mode=CacheMode.BYPASS

)

async with AsyncWebCrawler(config=browser_config) as crawler:

result = await crawler.arun(

url="https://example.com/products",

config=run_config

)

# Parse kết quả JSON

products = json.loads(result.extracted_content)

print(f"✓ Đã trích xuất {len(products)} sản phẩm")

print(json.dumps(products[0], indent=2, ensure_ascii=False))

if __name__ == "__main__":

asyncio.run(extract_structured_data())Phương pháp này rất nhanh vì không cần gọi API LLM, phù hợp cho các website có cấu trúc HTML rõ ràng.

Xử lý dynamic content với JavaScript execution

Nhiều website hiện đại dùng JavaScript để load nội dung động (infinite scroll, lazy loading, click để xem thêm). Crawl4AI hỗ trợ thực thi JavaScript tùy chỉnh:

import asyncio

from crawl4ai import AsyncWebCrawler, BrowserConfig, CrawlerRunConfig, CacheMode

async def crawl_dynamic_content():

# JavaScript để click tabs và đợi nội dung load

js_code = """

(async () => {

const tabs = document.querySelectorAll(".tab-menu > div");

for(let tab of tabs) {

tab.scrollIntoView();

tab.click();

await new Promise(r => setTimeout(r, 500)); // Đợi 500ms

}

})();

"""

browser_config = BrowserConfig(headless=False, verbose=True) # headless=False để xem browser

run_config = CrawlerRunConfig(

js_code=[js_code], # Thực thi JS trước khi extract

cache_mode=CacheMode.BYPASS

)

async with AsyncWebCrawler(config=browser_config) as crawler:

result = await crawler.arun(

url="https://example.com/dynamic-page",

config=run_config

)

print(result.markdown[:1000])

if __name__ == "__main__":

asyncio.run(crawl_dynamic_content())Tích hợp với LangChain cho RAG pipeline

Crawl4AI tích hợp mượt mà với LangChain để xây dựng hệ thống RAG:

from crawl4ai import AsyncWebCrawler

from langchain.text_splitter import CharacterTextSplitter

from langchain.schema.document import Document

from langchain.vectorstores import FAISS

from langchain_huggingface import HuggingFaceEmbeddings

async def crawl_for_rag():

# 1. Crawl website

async with AsyncWebCrawler() as crawler:

result = await crawler.arun("https://docs.python.org/3/tutorial/")

# 2. Chuyển markdown thành LangChain Document

doc = Document(

page_content=result.markdown,

metadata={"source": result.url, "title": result.title}

)

# 3. Chunking

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=200)

chunks = text_splitter.split_documents([doc])

# 4. Tạo vector store

embeddings = HuggingFaceEmbeddings(model_name="all-MiniLM-L6-v2")

vectorstore = FAISS.from_documents(chunks, embeddings)

# 5. Query

query = "How to use list comprehension in Python?"

docs = vectorstore.similarity_search(query, k=3)

print(f"✓ Đã index {len(chunks)} chunks")

print(f"✓ Top result cho query: {docs[0].page_content[:200]}")

if __name__ == "__main__":

import asyncio

asyncio.run(crawl_for_rag())Ví dụ này cho thấy workflow hoàn chỉnh: crawl → chunking → embedding → retrieval.

Mẹo tối ưu hóa

- Sử dụng caching: Bật

CacheMode.ENABLEDđể tránh crawl lại các URL đã crawl, tiết kiệm thời gian và băng thông. - Crawl song song: Dùng

arun_many()để crawl nhiều URL cùng lúc, tăng tốc gấp nhiều lần. - Lọc nội dung thông minh: Sử dụng

fit_markdownthay vìraw_markdownđể có nội dung đã được lọc nhiễu bằng thuật toán BM25. - Custom browser profile: Tạo profile với cookies và authentication state để crawl các trang cần đăng nhập.

- Proxy rotation: Cấu hình proxy trong

BrowserConfigđể tránh bị chặn IP khi crawl quy mô lớn.

Crawl4AI là một công cụ mạnh mẽ và hiện đại, được thiết kế đặc biệt cho thời đại AI với khả năng chuyển đổi nội dung web thành dữ liệu sạch, có cấu trúc và sẵn sàng sử dụng cho các mô hình ngôn ngữ lớn. So với các giải pháp truyền thống như BeautifulSoup và Scrapy, Crawl4AI vượt trội về tốc độ, khả năng xử lý dynamic content và sự tích hợp với các framework AI phổ biến.

Với cộng đồng 50,000+ developers và hơn 55,000 stars trên GitHub, Crawl4AI đang trở thành tiêu chuẩn mới cho web crawling trong các ứng dụng AI. Dù bạn đang xây dựng chatbot, hệ thống RAG, hay chỉ đơn giản là cần thu thập dữ liệu web cho nghiên cứu, Crawl4AI là lựa chọn đáng thử nghiệm.