Hướng dẫn cài đặt OpenWebUI với Docker cho Home Lab

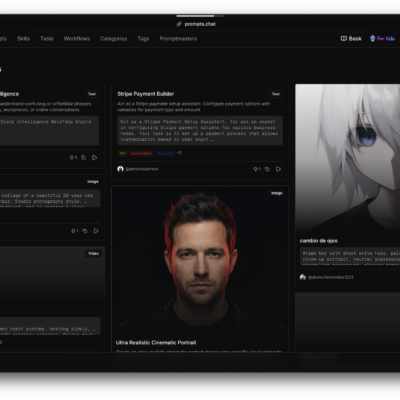

Nếu bạn đang đọc bài này, có lẽ bạn đã từng mơ về việc xây dựng một “phòng thí nghiệm” AI ngay tại nhà – nơi bạn có thể chạy các mô hình ngôn ngữ mạnh mẽ như Llama hay Mistral mà không phụ thuộc vào các dịch vụ lưu trữ đám mây đắt đỏ. Hôm nay, mình sẽ hướng dẫn bạn cài đặt OpenWebUI, một giao diện web mã nguồn mở tuyệt vời để quản lý và tương tác với các mô hình AI cục bộ. OpenWebUI giống như “ChatGPT cá nhân” của bạn, nhưng chạy hoàn toàn trên máy tính tại nhà, tích hợp với Ollama (một công cụ chạy mô hình AI cục bộ).

Là một người đam mê home lab đã thử nghiệm đủ thứ từ NAS đến server tự chế. Mình sẽ giải thích mọi thứ một cách đơn giản và dễ hiểu. Bạn chỉ cần kiến thức cơ bản về Docker (như chạy lệnh docker run), và mình cam đoan bạn sẽ thành công. Bài viết này sẽ dẫn bạn từ A đến Z, với các bước chi tiết, code block dễ copy-paste. Sẵn sàng chưa? Hãy bắt đầu!

Tại sao OpenWebUI lại tuyệt vời cho Home Lab của bạn?

Trước tiên, hãy nói về lý do bạn nên thử OpenWebUI. Trong thế giới AI năm 2025, việc tự host mô hình tại nhà đang hot hơn bao giờ hết – tiết kiệm chi phí, bảo mật dữ liệu, và tùy chỉnh theo ý thích. OpenWebUI là giao diện web frontend cho Ollama, cho phép bạn:

- Trò chuyện với mô hình AI qua trình duyệt.

- Quản lý nhiều mô hình (như tải về, xóa, hoặc chuyển đổi).

- Tạo chatbot tùy chỉnh cho dự án cá nhân, như trợ lý gia đình hoặc công cụ học tập.

Nó mã nguồn mở, miễn phí, và chạy mượt mà trên phần cứng home lab phổ biến như PC cũ hoặc Raspberry Pi (với một số điều chỉnh). Mình đã dùng nó để xây dựng một “AI gia sư” giúp con mình học toán – siêu thú vị! Nếu bạn đang mệt mỏi với việc gõ lệnh terminal, OpenWebUI sẽ làm cuộc sống dễ dàng hơn.

Yêu cầu hệ thống và chuẩn bị

Để cài đặt thành công, bạn cần một số thứ cơ bản. Đừng lo, mình sẽ liệt kê rõ ràng và giải thích tại sao chúng quan trọng.

- Phần cứng:

- Máy tính chạy Linux (Ubuntu khuyến nghị), Windows, hoặc macOS. Một PC với CPU đa lõi (như Intel i5 hoặc tương đương) và ít nhất 8GB RAM là đủ cho mô hình nhỏ. Nếu chạy mô hình lớn (như Llama 70B), cần GPU NVIDIA với ít nhất 8GB VRAM (ví dụ: RTX 3060).

- Dung lượng lưu trữ: Ít nhất 20GB trống cho mô hình và Docker images. Nếu dùng Raspberry Pi, nên chọn Pi 5 với 8GB RAM cho hiệu suất tốt.

- Phần mềm:

- Docker và Docker Compose: Đây là nền tảng chính. Nếu chưa có, cài Docker từ trang chính thức. Docker Compose thường đi kèm, nhưng kiểm tra bằng lệnh

docker-compose --version. - Ollama: OpenWebUI cần Ollama làm backend. Chúng ta sẽ cài nó qua Docker.

- Trình duyệt web: Chrome hoặc Firefox để truy cập giao diện.

- Kiến thức cơ bản: Biết mở terminal và chạy lệnh. Nếu bạn từng chạy container đơn giản, bạn sẽ ổn.

- Docker và Docker Compose: Đây là nền tảng chính. Nếu chưa có, cài Docker từ trang chính thức. Docker Compose thường đi kèm, nhưng kiểm tra bằng lệnh

- Môi trường mạng: Chạy trên mạng nội bộ (localhost) để an toàn. Nếu muốn truy cập từ xa, mình sẽ lưu ý về bảo mật sau.

Nếu thiếu gì, hãy cài trước. Mình khuyên dùng Ubuntu vì dễ quản lý. Sẵn sàng rồi? Tiếp theo là phần chính: cài đặt!

Hướng dẫn cài đặt với Docker Compose

Mình sẽ hướng dẫn từng bước. Chúng ta dùng Docker Compose để chạy cả Ollama và OpenWebUI trong container, dễ quản lý và cập nhật. Toàn bộ quá trình mất khoảng 15-30 phút.

Bước 1: Tạo thư mục dự án

Mở terminal và tạo một thư mục mới:

mkdir openwebui-lab

cd openwebui-labBước 2: Tạo file Docker Compose

Tạo file docker-compose.yml bằng lệnh nano docker-compose.yml (hoặc dùng editor yêu thích). Copy-paste nội dung sau:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

volumes:

- ollama-data:/root/.ollama

ports:

- "11434:11434"

restart: unless-stopped

environment:

- OLLAMA_API_BASE=http://ollama:11434

openwebui:

image: ghcr.io/open-webui/open-webui:main

container_name: openwebui

depends_on:

- ollama

volumes:

- openwebui-data:/app/backend/data

ports:

- "8080:8080"

environment:

- OLLAMA_API_BASE_URL=http://ollama:11434/api

- WEBUI_SECRET_KEY=your_secret_key_here # Thay bằng key mạnh

restart: unless-stopped

volumes:

ollama-data:

openwebui-data:Giải thích ngắn gọn:

- ollama service: Chạy Ollama backend. Volume lưu mô hình để không mất khi restart.

- openwebui service: Giao diện web. Depends_on đảm bảo Ollama chạy trước. Port 8080 là nơi bạn truy cập.

- Environment: Đặt API base để OpenWebUI kết nối với Ollama. Thay

your_secret_key_herebằng chuỗi ngẫu nhiên (dùngopenssl rand -hex 32để tạo).

Lưu file và thoát.

Bước 3: Khởi Động Các Container

Chạy lệnh:

docker-compose up -d-d nghĩa là chạy ở background. Kiểm tra bằng docker ps – bạn sẽ thấy hai container đang chạy.

Bước 4: Tải mô hình AI đầu tiên

Vào container Ollama để tải mô hình (ví dụ: Llama 3 nhỏ):

docker exec -it ollama ollama pull llama3Điều này tải mô hình về. Nếu có GPU, Ollama sẽ tự dùng (cần NVIDIA Docker toolkit nếu trên Linux).

Bước 5: Kiểm tra và xử lý lỗi

- Nếu lỗi port: Thay đổi port trong yml (ví dụ: 8081:8080).

- Không kết nối: Kiểm tra

docker logs openwebuiđể xem log. - Nếu RAM thấp: Chọn mô hình nhỏ hơn như Phi-3.

Bây giờ, hệ thống đã sẵn sàng!

Sử dụng OpenWebUI lần đầu tiên

Chúc mừng! Mở trình duyệt và truy cập http://localhost:8080 (hoặc IP máy nếu nếu truy cập trong mạng LAN, còn nếu truy cập từ mạng khác hoặc public ra internet thì có thể dùng Cloudflare Tunnels). Bạn sẽ thấy trang đăng ký – tạo tài khoản với email và mật khẩu. Sau đó, đăng nhập.

Thiết lập ban đầu

- Kết nối với Ollama: OpenWebUI sẽ tự phát hiện Ollama qua API. Nếu không, vào Settings > Connections và đặt URL là

http://ollama:11434. - Chọn Mô Hình: Vào tab Models, bạn sẽ thấy llama3 đã tải. Chọn nó để chat.

- Thử Chat: Nhập câu hỏi như “Hello, tell me about home labs.” AI sẽ trả lời dựa trên mô hình!

Mẹo sử dụng

- Tùy Chỉnh: Tạo “WebUI” mới (như chatbot chuyên biệt) bằng cách vào Workspaces.

- Tích Hợp: Kết nối với các công cụ khác như LangChain qua API (xem docs tại openwebui.com).

- Bảo Mật: Đổi secret key và dùng HTTPS nếu expose ra ngoài (dùng Nginx reverse proxy).

- Mở Rộng: Tải thêm mô hình bằng lệnh

ollama pulltrong container, nhưollama pull mistral.

Mình thường dùng nó để tạo script tự động hóa home lab – siêu tiện!

Bắt đầu hành trình AI của bạn ngay hôm nay

Từ một ý tưởng đơn giản, bạn giờ có OpenWebUI chạy mượt mà trong home lab, sẵn sàng cho vô số dự án. Mình hy vọng hướng dẫn này truyền cảm hứng để bạn thử nghiệm – có lẽ xây dựng AI giám sát nhà cửa hoặc trợ lý học tập. Nếu gặp vấn đề, comment bên dưới hoặc tham gia cộng đồng Reddit r/selfhosted. Home lab là về sự sáng tạo, và OpenWebUI là bước đệm hoàn hảo. Chúc bạn vui vẻ với AI tại nhà!